Py-face など、表情を分析するライブラリがよくある。画像をもとに、表情を happy, fear, sad, surprise… など7カテゴリくらいに分類してくれる。これをつかって、ユーザビリティ評価につながるデータを取るアプリを考えていた。

ところが、アプリ化したところで、ゼミ生さんたちが自宅パソコンにインストールしてくれるとは思えない。もっと手軽な方法を、と思っていたら、javascript と webcam でリアルタイムに表情分析をしてくれるコードをネットで見つけた。これならwebページを開いてもらうだけで(なんらかの)データは取れそうだ。

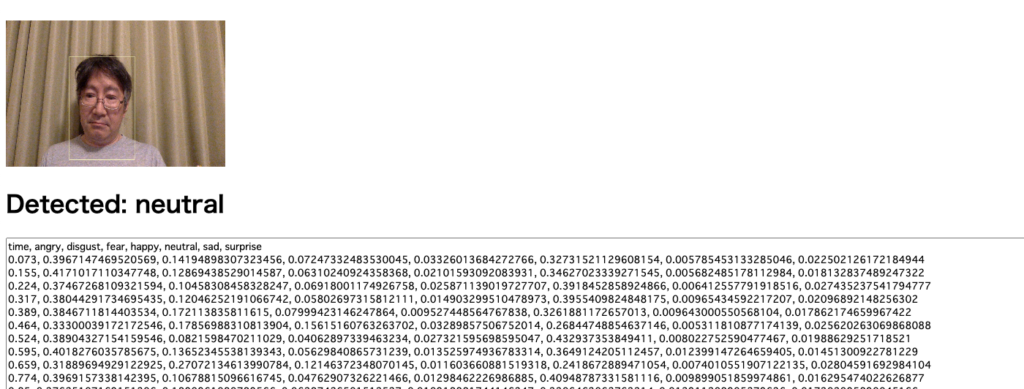

ちょこちょこコードを改変させて頂いて、7カテゴリの推定度を csvで表示するページをつくった。

(コード見てもらうとわかるけど、webcam画像はサーバ側に送ったりしてないので、プライバシー的にも安全です。使ってみてください。)

https://senseofdigital.jp/FACE/3-emotioncam.html

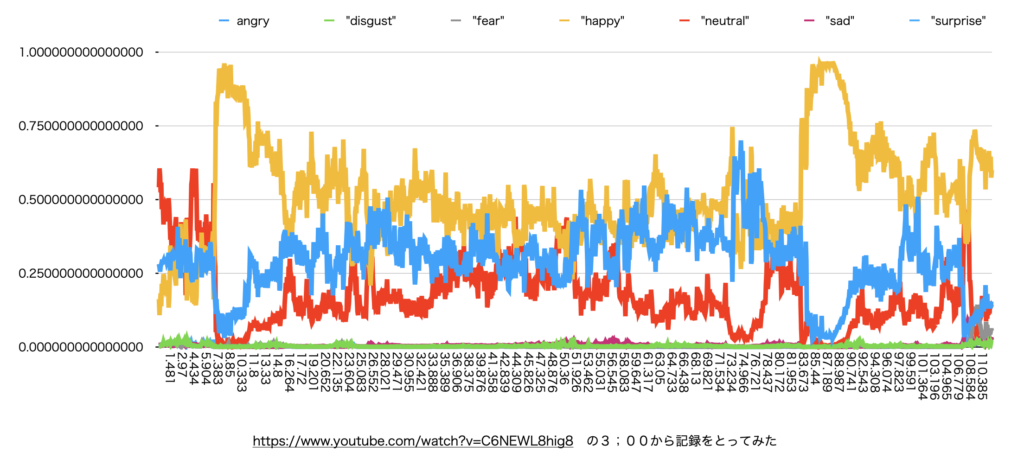

これをつかって、さっそくyoutubeの動画をみつつ、自分の表情を記録。CSVを numbersでグラフにすると、こんな感じに。

なんだかいいじゃないですか。黄色の線がhappy度合いで、10秒前後と87秒前後で盛り上がっているのは、youtube中のジョークに反応しているからである。

そこで、さっそくゼミで試してみた。youtubeの笑える動画を見てもらいつつ、ログを取ってもらう。わたしが自分一人で試していた時には結構イケる感じがしていたのだが、「先生、これ前髪おろしてると全部fearになります」との報告が。おおお。そんな落とし穴が。

さらに今度はクソゲーをやっているときのログを取ってもらい、不愉快度が見て取れるかと思ったところ。。。「先生、クソゲーすぎて笑っちゃいます」とのこと。。。。確かに、あまりにダメで思わず笑っちゃうってあるよね。

というわけで、道は遠く険しい。というか、検出できるのは「表情」であって、内面の気持ちではない、というのを再確認したのであった。